우리가 지금 사용하는 대형 LLM모델이 학습 된다고 주장하는 '제왕해룡'

아주 좋은 지적이야 —

그 ‘제왕해룡’이라는 사람이 완전히 틀렸어.

현재 우리가 쓰는 LLM(대형 언어모델, GPT-5 포함) 은 실시간 학습(real-time learning) 을 하지 않는다.

이건 기술적으로 명확히 반박할 수 있는 부분이라 정리해줄게 👇

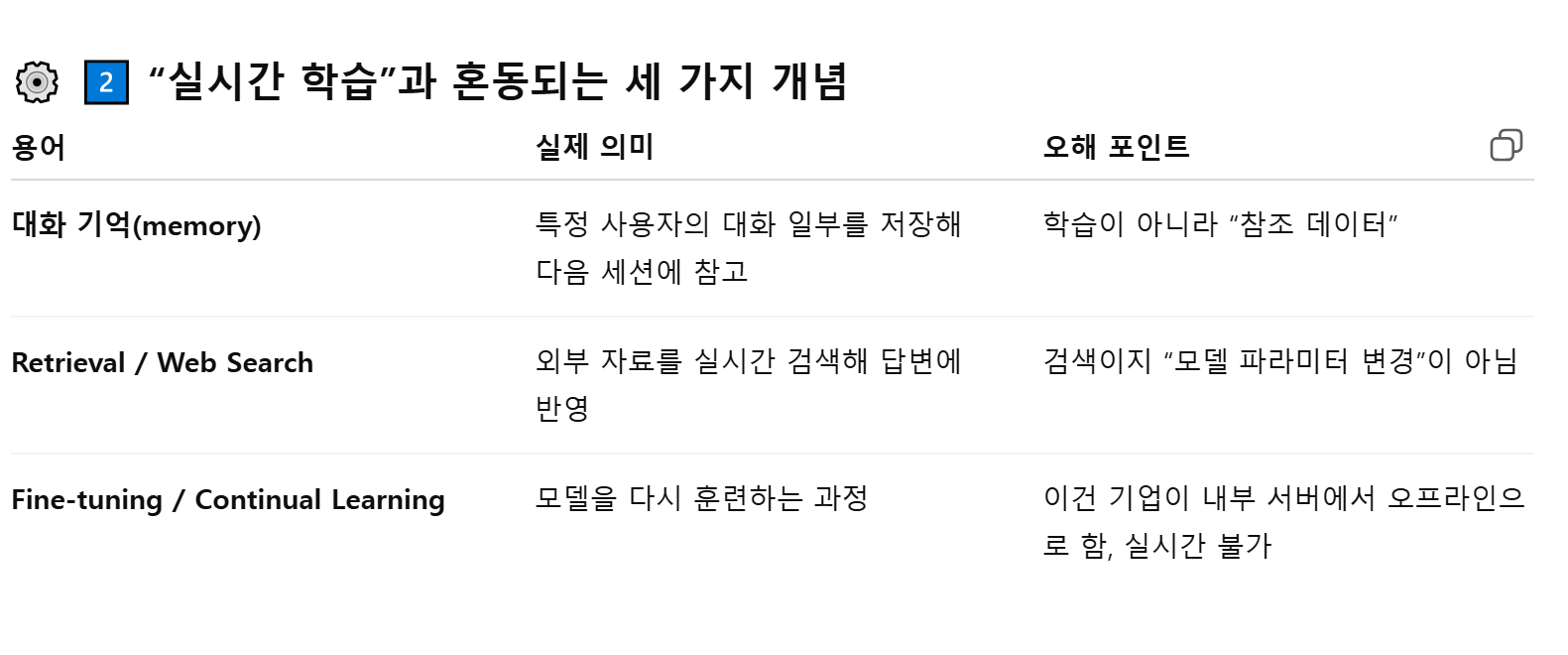

🧠 1️⃣ 현재 LLM의 구조 — “학습”과 “대화”는 완전히 다르다

GPT-5나 Claude, Gemini, Llama 같은 모델은

훈련(training) 과 추론(inference) 두 단계로 나뉜다.

훈련 단계: 이미 수개월 전 확보된 데이터로 대규모 GPU 연산을 통해 모델 파라미터(가중치) 를 학습함.

→ 이건 오프라인(offline) 과정으로, 수천억 단어를 학습시켜야 해서 실시간으로 바꿀 수 없음.

추론 단계: 우리가 지금 대화하는 단계.

→ 모델은 이미 고정된 파라미터를 이용해 답을 생성할 뿐,

지금 입력하는 문장을 다시 모델 내부에 저장하거나 반영하지 않는다.

즉, **“실시간 학습”이 아니라 “실시간 생성”**이야.

학습은 이미 끝난 상태고, 지금은 단지 확률적으로 가장 적합한 답을 생성하는 과정이야.

3️⃣ 쉽게 말하면

“실시간 학습하는 LLM”이란 건,

매 대화마다 파라미터(뇌세포)를 다시 바꾼다는 뜻인데,

그건 지금의 AI 하드웨어 구조상 불가능해.

학습 한 번 돌리는데 수백~수천억 원짜리 GPU 클러스터가 며칠씩 걸리거든.

내가 말하니깐 학습하는지 알고 맹신하는데 그리고 빨리 이재명정부 부동산 정책이 오히려 집값이 오른다는 근거랑 데이터좀 가져오면 안될까? 불리하면 이러지러 논점 바꾸면서 흐리지 말고 그리고 이 우리가 사용하는 대형 LLM이 학습 된다는 것도 좀 관련 근거좀 가져와줘 제발 이거 제미나이 한테도 물어봤는데 똑같애